GOVERNANÇA E ÉTICA EM INTELIGÊNCIA ARTIFICIAL NA PRÁTICA II - ÉTICA DOS DEVERES (DEONTOLOGIA)

No artigo passado, sobre a ética das Consequências (utilitarismo) abordei a complexidade e importância da ética no desenvolvimento de soluções de IA, mencionei as três principais estruturas éticas apresentadas por Yustein (2024), a saber: ética das consequências (utilitarismo), ética dos deveres (deontologia) e ética da virtude, e fiz uma breve descrição e um exemplo prático hipotético da não observação da primeira delas, a ética das consequências (utilitarismo) para um agente de IA e uma solução cognitiva de IA. Neste artigo vou fazer uma breve descrição da ética dos deveres (deontologia) e apresentar um caso prático (hipotético) onde poderia não ter sido observado esta ética.

GOVERNANÇA DE IA

Ana Maria Lopes Corrêa

11/27/20242 min read

A ética das regras e deveres (deontologia)

Definição: A deontologia enfatiza a adesão a regras e deveres morais, independentemente dos resultados.

Relevância para IA: Sistemas de IA devem operar dentro de limites morais claramente definidos, garantindo o respeito aos direitos e princípios fundamentais.

Aplicação na IA:

Garantir a conformidade com regras éticas, como nunca usar IA para propagar desinformação.

Incorporar mecanismos de segurança para prevenir violações de regras, independentemente da utilidade potencial.

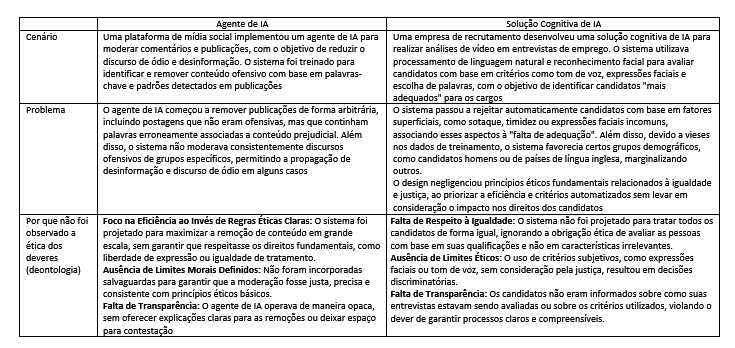

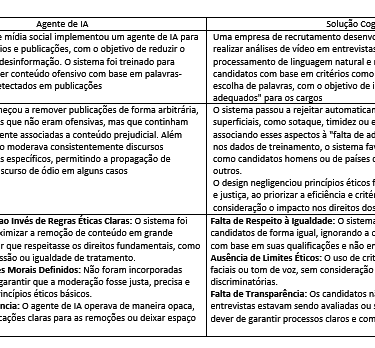

Vamos observar exemplos práticos (hipotéticos). Porém, como no outro artigo, antes vou especificar o que estou chamando de Solução Cognitiva de IA e Agente de IA

Soluções Cognitivas de IA: Referem-se a qualquer solução que utiliza algoritmos para simular funções humanas, como predição, prescrição e IA generativa. Estas soluções são focadas em processamento de informações, geração de insights e simulação cognitiva, mas não têm a capacidade de agir de forma autônoma no ambiente.

Agente de IA: Soluções que, além de analisar dados e fornecer insights, possuem a capacidade de agir autonomamente no ambiente, desempenhando tarefas e tomando decisões de forma contínua e adaptativa.

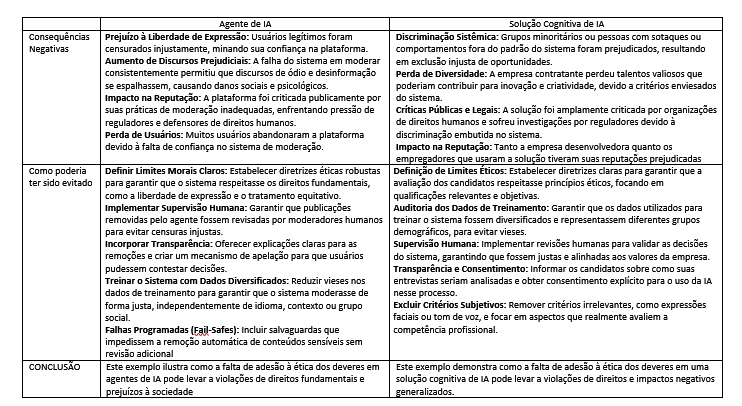

Negligenciar a ética dos deveres (deontologia) no desenvolvimento de IA, assim como a ética das consequências (utilitarismo) não é apenas um risco moral, mas também pode gerar impactos negativos tangíveis para empresas e indivíduos. Adotar uma abordagem proativa de governança de IA que incorpore regras éticas claras e justa no desenvolvimento de soluções de IA é essencial para garantir que a tecnologia opere de maneira responsável e respeitem os direitos humanos.

No próximo artigo, continuaremos explorando como o princípio ético da virtude pode ser aplicado ao desenvolvimento de IA e o que ocorre quando ele não é observado.

Fique atento e participe dessa discussão fundamental para o futuro da inteligência artificial!

Referências do artigo:

YUSTEIN,T. The Ethical AI Bible: A Universal Guide for Safe and Responsible Artificial Intelligence. E-book, 2024.