IA Confiável: Dados, Modelos e Processos Precisam de Governança

A Inteligência Artificial (IA) Confiável e Responsável vai além de tecnologias avançadas: trata-se de desenvolver e utilizar sistemas que sigam princípios éticos, promovam justiça, transparência e respeito aos direitos humanos. Para isso, confiança é a palavra-chave.

GOVERNANÇA DE IA

Ana Maria Lopes Corrêa

5/12/20253 min read

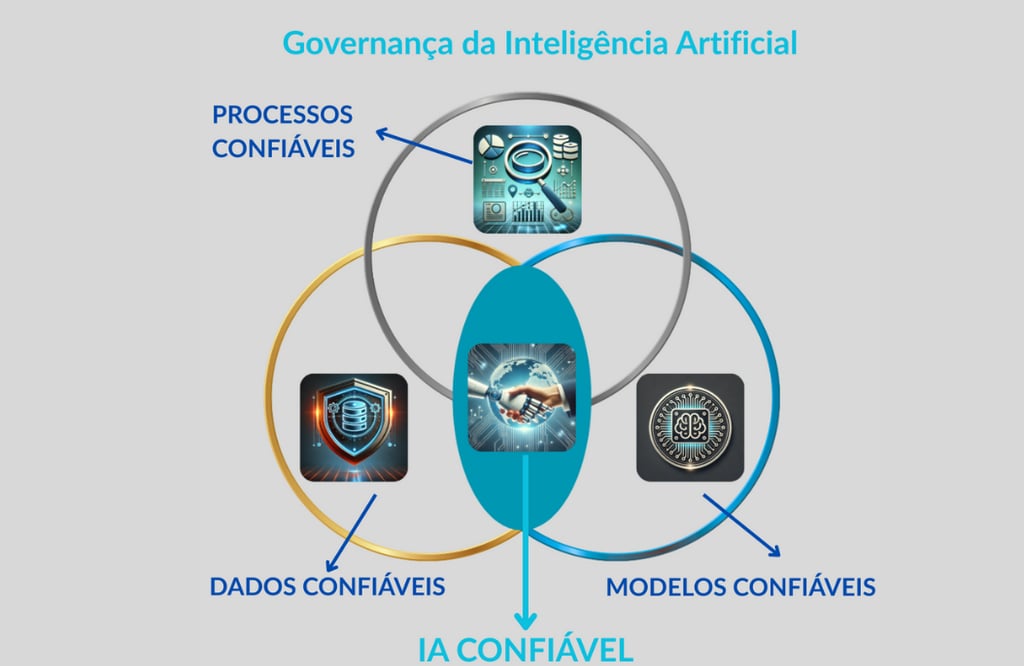

IA Confiável e Responsável é o desenvolvimento e uso de sistemas de inteligência artificial que seguem princípios éticos, promovem a justiça, a transparência e o respeito aos direitos humanos. Uma solução de IA deve utilizar práticas que demostrem confiança no seu PROCESSO de desenvolvimento, implantação e monitoramento, na escolha, treino e validação dos MODDELOS e na preparação e manutenção dos DADOS (ALZUBAIDI et al., 2023).

Ou seja, ela precisa estar presente em três pilares fundamentais:

Dados bem preparados e mantidos,

Modelos cuidadosamente treinados e validados, e

Processos de desenvolvimento, implantação e monitoramento bem governados.

É exatamente nesse ponto que a Governança de IA se torna essencial.

O papel da Governança de IA: Governança de IA é o conjunto de políticas, diretrizes e práticas que asseguram que a IA esteja alinhada com valores éticos, regulações, metas de negócio e expectativas sociais. Ela garante que os três pilares — dados, modelos e processos — sejam tratados com o a atenção necessária.

Para ilustrar como isso funciona na prática, veja três exemplos onde apenas um dos pilares falha, comprometendo toda a solução:

1. Quando os Dados falham (modelo e processo bons)

Uma fintech lançou um sistema de IA para detectar fraudes em transações bancárias.

O modelo era bem desenvolvido, com técnicas robustas de aprendizado supervisionado.

Processo sólido: Avaliações regulares, revisões éticas e compliance fortes. Prestação de contas e responsabilidades definidas, transparência e explicabilidade especificadas, riscos éticos, de justiça e equidade, proteção, privacidade, integridade e qualidade dos dados, contextos sociais e de segurança e robustez analisados, avaliados e mitigados no ciclo de vida.

Mas os dados usados vinham de registros históricos incompletos e desatualizados, com viés de registro (ex.: dados de transações recentes e digitais eram muito mais detalhados do que dados antigos).

Impactos: A IA apresentava alta precisão nos testes internos, mas na prática deixava passar fraudes mais sofisticadas ou marcava transações legítimas como suspeitas em perfis fora do padrão dos dados históricos.

Resultados: Aumento de reclamações de clientes; Falsos positivos elevados (restrição de contas sem necessidade) e Imagem arranhada, mesmo com compliance em dia.

Lição: Dados ruins comprometem até os melhores modelos e processos.

2. Quando o Modelo é o elo fraco (dados e processos bons)

Uma grande rede varejista implementou um sistema de recomendação personalizada.

Os dados eram excelentes: captavam comportamento online e offline, perfis detalhados e atualizados.

Processo sólido: Avaliações regulares, revisões éticas e compliance fortes. Prestação de contas e responsabilidades definidas, transparência e explicabilidade especificadas, riscos éticos, de justiça e equidade, proteção, privacidade, integridade e qualidade dos dados, contextos sociais e de segurança e robustez analisados, avaliados e mitigados no ciclo de vida.

Porém, o modelo escolhido era simplório: um algoritmo básico de filtragem colaborativa, sem atualização dinâmica nem capacidade de lidar com contextos complexos.

Impactos: As recomendações eram genéricas e repetitivas, não captavam nuances como preferências sazonais ou mudanças de comportamento.

Resultados: Taxa de conversão menor do que esperado; Usuários começavam a ignorar recomendações por achá-las irrelevantes e Perda de oportunidade de crescimento de receita, mesmo com toda a infraestrutura certa.

Lição: Bons dados e processos não compensam um modelo mal escolhido.

3. Quando o Processo é falho (dados e modelo bons)

Um hospital implantou um sistema de triagem automatizada para emergências.

Os dados clínicos eram bem estruturados e representativos.

O modelo era avançado, usando IA médica validada e treinada para vários perfis demográficos.

Mas o processo era falho: não havia auditoria contínua, nem documentação clara para explicar decisões, e as atualizações do modelo eram feitas sem critérios padronizados de validação. riscos éticos, de justiça e equidade, proteção, privacidade, integridade e qualidade dos dados, contextos sociais e de segurança e robustez não foram analisados, avaliados e muito menos mitigados no ciclo de desenvolvimento

Impactos: Apesar do bom desempenho inicial, houve erros não detectados após atualizações: o modelo começou a priorizar pacientes com sintomas menos graves por causa de uma falha de ajuste que passou despercebida.

Resultados: Atrasos críticos em atendimentos graves; Desconfiança entre médicos e gestores e Revisão emergencial e bloqueio temporário do sistema.

Lição: Sem um processo governando corretamente, até IA de qualidade se torna perigosa.

Para uma IA ser realmente confiável e responsável, os três pilares precisam estar em harmonia:

✅ Dados confiáveis

✅ Modelos robustos

✅ Processos bem governados

E a Governança de IA é o elo que une todos esses elementos.

Gostaria de aprender como implementar a Governança da IA de forma estruturada e prática?

Conheça o nosso treinamento Governança da IA Aplicada

Referência bibliográfica desta publicação: ALZUBAIDI, L. et al. Towards Risk-Free Trustworthy Artificial Intelligence: Significance and Requirements. International Journal of Intelligent Systems., Oct. 26, 2023, Article ID 4459198, 41p. Disponível em: https://lnkd.in/d2JwSz8t